分享一个私有化部署开源AI模型的方法,此文以通义千问为例。

安装ollama

本次示例在 linux 环境安装,需要用到 ollama 工具。ollama 是一个开源平台,提供了AI模型管理工具也叫ollama,可以用来下载、安装、删除、运行、停止开源模型。

ollama 官网地址:https://ollama.com/

ollama 获取地址:https://ollama.com/download

ollama 开源模型:https://ollama.com/library

打开下载地址 https://ollama.com/download ,官方给的 linux 安装方案很简单,如下图。只需要运行一个远端脚本,就能自动根据系统硬件情况下载对应的安装包来安装。

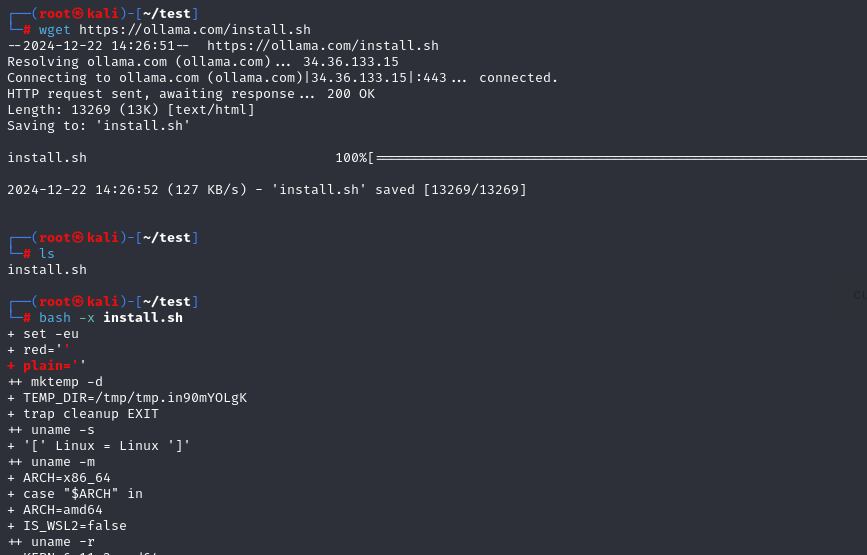

但是实际操作中并没有那么简单,可能是国内网络环境不稳定导致的。既然是个脚本,就手动调试一下吧。于是就下载了脚本看看具体情况。

下载:wget https://ollama.com/install.sh

下载后执行: bash -x install.sh 并查看哪里卡住了。

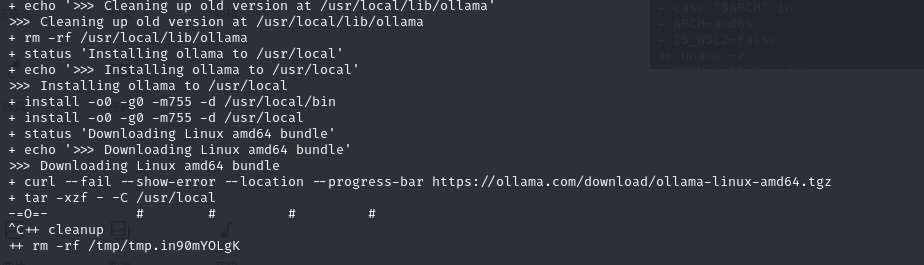

原来是因为文件下载的问题,如下图。

于是手动下载文件,并修改脚本,跳过下载的部分。wget下载不成功,就用浏览器下载。

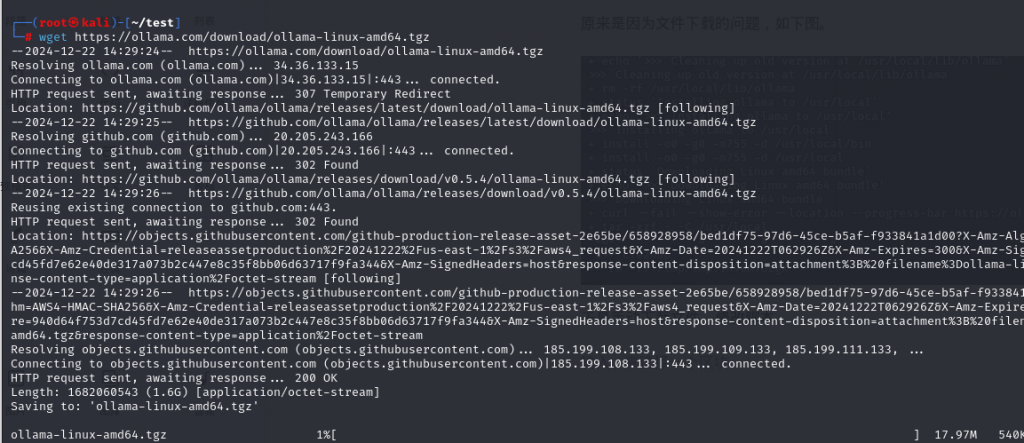

wget https://ollama.com/download/ollama-linux-amd64.tgz

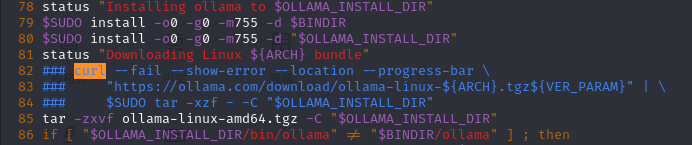

等下载完成后,修改 install.sh 脚本,如下图。把 82~84 行注释掉,增加第 85 行。

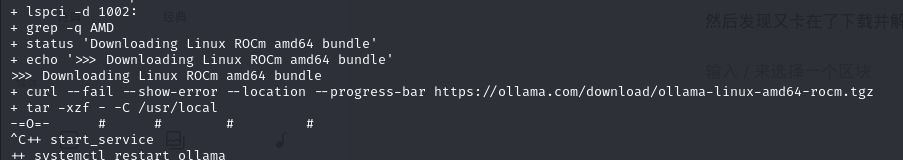

然后继续执行: bash -x install.sh 。发现又卡在了下载并解压的位置。如下图:

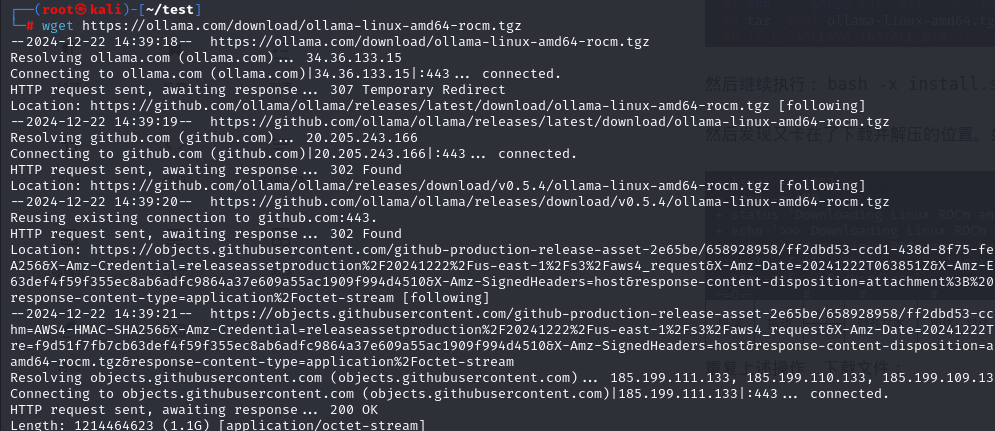

重复上述操作,下载文件:wget https://ollama.com/download/ollama-linux-amd64-rocm.tgz

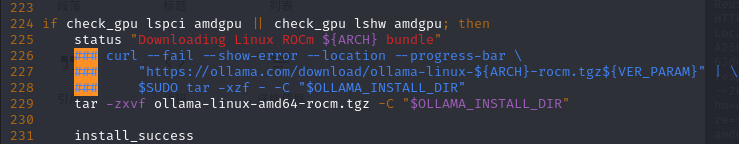

修改 install.sh 脚本,如下图。把 226~228 行注释,增加第 229 行。

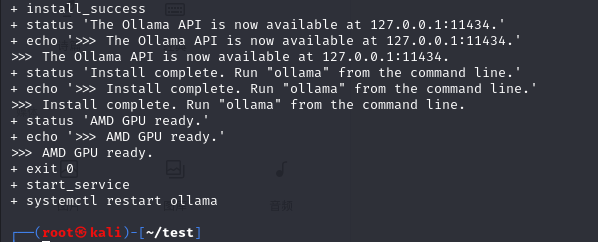

继续执行 bash -x install.sh ,最终安装成功。

如果硬件配置不一样,所下载的安装包也不一样,需要根据实际情况调整。

运行模型

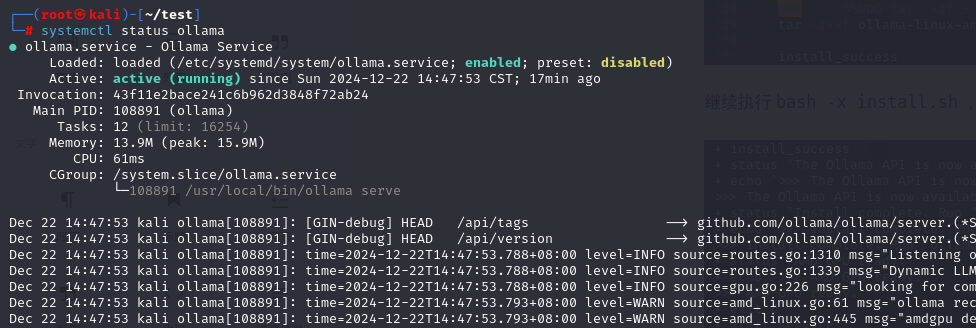

查看 ollama 的运行状态。systemctl status ollama

如果没运行则,可手动启动:systemctl start ollama 。

下一步拉取开源模型,可以在 https://ollama.com/library 查看有哪些模型可以获取。

由于我的电脑性能不高,所以获取一个 qwen2.5 的 0.5b 的模型来运行,更大的模型推理会比较慢。

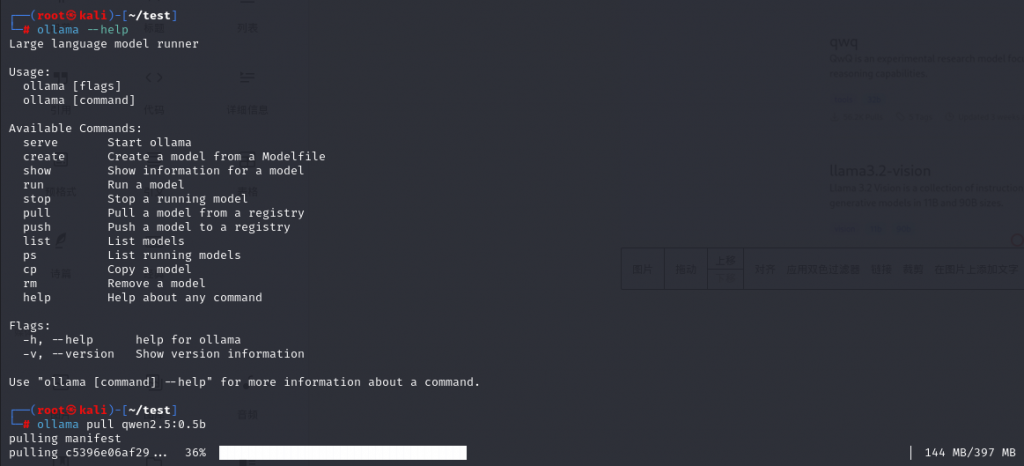

指令:ollama pull qwen2.5:0.5b

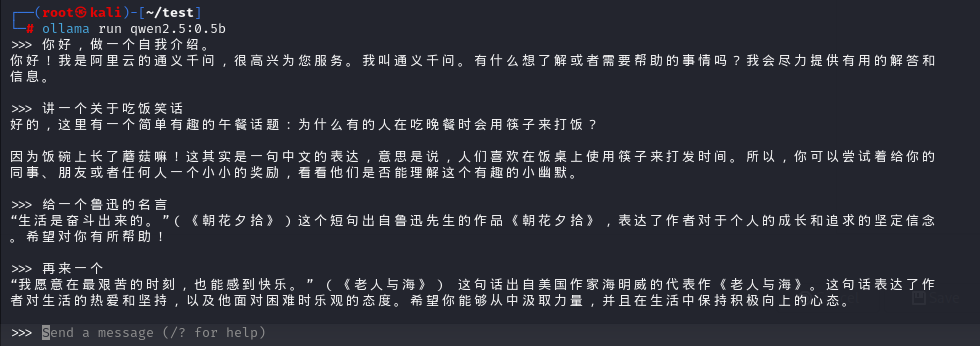

等获取成功了,运行此模型:ollama run qwen2.5:0.5b 。模型太小,推理的结果给人感觉不靠谱了 0_0。也可以尝试其他模型下载下来玩玩。

发表回复